Как закрыть сайт от индексации в robots.txt

Содержание:

- Закрытие от индексации элементов на страницах сайта

- Причины использования

- Закрытие отдельно взятых элементов

- Способ 1. Создать файл Site Closed

- Когда следует использовать режим обслуживания WordPress

- Настройка оформления страницы техобслуживания

- Ход эксперимента

- Комментарии в robots.txt

- Контент

- Результаты эксперимента: AJAX

- Карта сайта в robots.txt — Sitemap.xml

- Разрешить индексацию robots.txt — Allow

- Индексация сайта в поиске

- Запрещаем индексацию страницы

- Как проверить файл robots.txt?

- Директива Clean-param в robots.txt

- Ошибки, на которые следует обратить внимание

- Закрываем от индексации поисковиков

- Запрещаем индексацию сайта

- Вывод

Закрытие от индексации элементов на страницах сайта

SEO-тег <noindex>

SEO-тег <noindex> не используется в официальной спецификации html, и был придуман Яндексом как альтернатива атрибуту nofollow. Пример корректного использования данного тега:

<!—noindex—>Любая часть страницы сайта: код, текст, который нужно закрыть от индексации<!—/noindex—>

Примеры использования тега <noindex> для закрытия от индексации элементов на страницах сайта:

- нужно скрыть коды счетчиков (liveinternet, тИЦ и прочих служебных);

- запрятать неуникальный или дублирующийся контент (copypast, цитаты и пр.);

- спрятать от индексации динамичный контент (например, контент, который выдается в зависимости от того, с какими параметрами пользователь зашел на сайт);

- чтоб хотя бы минимально обезопасить себя от спам-ботов, необходимо закрывать от индексации формы подписки на рассылку;

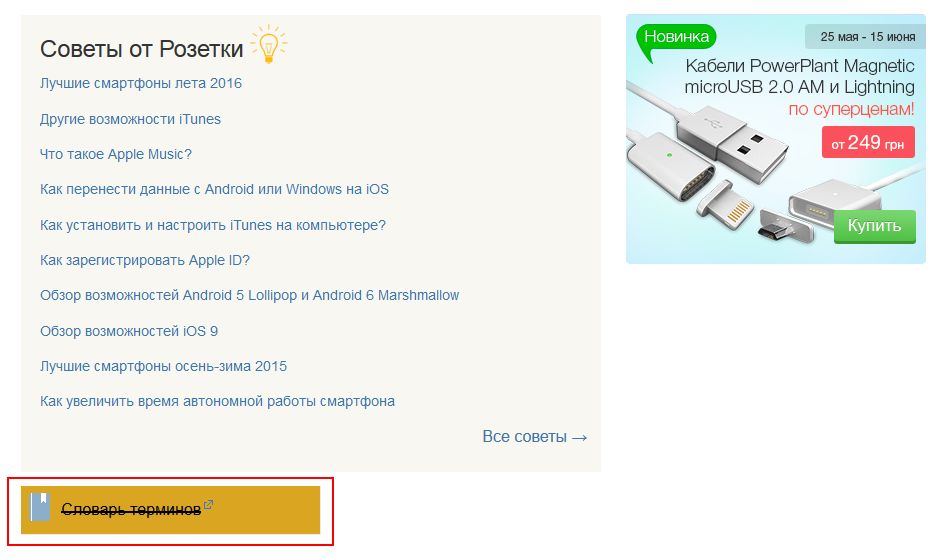

- закрыть информацию в сайдбаре (например, рекламный баннер, текстовую информацию, как это сделала Розетка).

Атрибут rel=»nofollow»

Если к ссылке добавить атрибут rel=»nofollow», тогда все поисковые системы, которые поддерживают стандарты Консорциума Всемирной паутины (а к ним относятся и Яндекс и Google) не будут учитывать вес ссылки при расчете индекса цитирования сайта.

Примеры использования атрибута rel=»nofollow» тега <a>:

- поощрение и наказание комментаторов вашего сайта. Т.е. спамерские ссылки в комментариях либо можно удалять, либо закрывать в nofollow (если ссылка тематична, но вы не уверены в ее качестве);

- рекламные ссылки или ссылки, размещенные «по бартеру» (обмен постовыми);

- не передавать вес очень популярному ресурсу, типа Википедии, Одноклассников и пр.;

- приоритезация сканирования поисковыми системами. Лучше закрыть от перехода по ссылкам для ботов Ваши формы регистрации.

SEOhide

Спорная технология, в сути которой с помощью javacript скрывать от поисковиков ненужный с точки зрения SEO-специалиста контент. А это «попахивает» клоакингом, когда пользователи видят одно, а поисковики – другое. Но давайте посмотрим на плючсы и минусы данной технологии:

Плюсы:

+ корректное управление статическим и анкорным весом;

+ борьба с переспамом (уменьшение количества ключевых слов на странице, так называемый показатель «тошноты» текста);

+ можно использовать для всех поисковых систем без ограничений, как в случае с noindex;

Минусы:

— вскоре поисковые системы научатся индексировать JS;

— в данный момент данная технология может быть воспринята поисковиками как клоакинг.

Подробнее об этой технологи смотрите в видео:

Причины использования

Такая заглушка используется на время технических работ, чтобы оповестить приходящих посетителей, что над сайтом ведутся работы и он скоро откроется.

С другой стороны сайт может некорректно работать во время тяжелых обновлений, внедрения новых функций и изменения дизайна, что может повлечь за собой потерю репутации.

Еще один вариант использования заглушки сайта — потребность разрекламировать проект прежде чем тот будет запущен.

В этом случае на заглушке размещают:

-

информацию о проекте;

-

ознакомительный контент (фотографии ассортимента, видео и т.п.);

-

таймер обратного отсчёта до полноценного открытия;

-

форму обратной связи;

-

ссылки на соцсети;

-

промокод на первую покупку.

Закрытие отдельно взятых элементов

Небольшие одностраничники, как правило, не нуждаются в сокрытии конкретных элементов. Однако крупные площадки, в которых содержится много служебных сведений, часто подвергаются процедуре сокрытия некоторых страниц и даже разделов. В качестве примера можно выделить панель администратора, кабинет пользователя, регистрационные формы, разделы «Избранное», «Корзина» и т.п.

Также рекомендую вам отключать индексацию «мусорного» содержания. К таковому можно отнести старые и неактуальные публикации, различные акции и специальные предложения, заметки в календаре. Сокрытие устаревших данных позволит сохранить актуальность всего ресурса. Также можно регулярно обновлять контент ресурса для того, чтобы не заниматься его сокрытием. Непосредственно запрет в рассматриваемом случае осуществляется при помощи команд, показанных на изображении снизу.

Способ 1. Создать файл Site Closed

Способ подразумевает кастомизацию стандартной заглушки, которая включается в главном модуле, кнопкой “Закрыть публичную часть сайта”.

Стандартная заглушка заменяется посредством создания файла site_closed.php в «/bitrix/php_interface/include» или «/local/php_interface/include».

Такая заглушка — обычная страница, поэтому размещенные на ней компоненты тоже будут работать. В то же время страница может быть собрана в

и никак не связана с дизайном сайта.

А такую заглушку мы используем на наших проектах. Если вам понравилась эта заглушка, то не пропустите — в конце статьи будет ссылка на скачивание.

Когда следует использовать режим обслуживания WordPress

Каждый разработчик сам решает, в какие моменты лучше закрыть сайт на обслуживание. Несмотря на это, рекомендую все же ознакомиться с возможными причинами, из-за которых стоит переводить сайт в этот режим:

- Ребрендинг. В таких случаях попросту невозможно оставить сайт без профилактического режима.

- Внесение корректировок на популярных страницах. Когда проводятся изменения малопосещаемых страниц, то можно обойтись без их отключения, но когда это касается веб-страниц с большим трафиком, то лучше их обезопасить и отключить на время работы.

- Установка нового плагина. Если это расширение влияет на работу всего сайта, обязательно позаботьтесь о режиме обслуживания.

- Восстановление сайта после DDoS-атаки – вопросов возникнуть не должно.

«Скоро появится» – такую надпись часто можно встретить на тех страницах, которые находятся в стадии разработки. Если вы не планируете размещать новую страницу до ее появления, то уведомлять о профилактических работах не потребуется.

Все вышесказанное можно объединить в один тезис – капитальный ремонт. Проще говоря, если проводятся крупные работы над страницей, первым делом позаботьтесь о ее деактивации.

Настройка оформления страницы техобслуживания

На вкладке «Дизайн» мы можем изменять внешний вид страницы технического обслуживания на которую попадают посетители сайта.

Здесь вы, прежде всего, вы можете изменить текст, который высвечивается на странице техобслуживания. Изменить тег title, заголовок страницы и ввести сюда какой-то свой текст. Так же, вы можете выбирать здесь цвет шрифта заголовка, текст шрифта основного текста, выбирать фон, загружать какое-то изображение в качестве фона.

После того, как вы зададите все эти настройки вам, конечно же, нужно нажать на кнопку «Сохранить настройки».

На вкладке «Mодули» у вас есть возможность добавить различные дополнительные элементы на страницу технического обслуживания. Например, такие как таймер обратного отсчета.

Для того, что бы это сделать в поле «Показывать обратный отсчет» выбираем «Да». Далее, выставляете определенную дату, либо часы, для обратного отсчета времени. Так же, здесь выбирается цвет для таймера. Для того, что бы он отобразился, нужно будет сохранить изменения.

Помимо таймера, здесь можно так же добавить поле «Подписаться». Для этого , так же, выбираем пункт «Да». Далее задаём в поле «Текст» пишем какой-то свой текст и выбираем для него цвет.

Здесь же можно выбрать, использовать Google Analytics или нет для страницы данного сайта, и если использовать, то вам здесь нужно будет вставить код отслеживания. После того как вы все задали, нажимаете на кнопку «Сохранить настройки».

Не смотря на то, что данный плагин очень много настроек, для того, что бы просто включить режим техобслуживания и запретить посетителям доступ к вашему сайту достаточно просто установить данный плагин, перейти в его настройки, поставить статус включено и нажать на кнопку «Сохранить настройки».

После того, как вы выполнили все необходимые манипуляции с вашим сайтом, не забудьте отключить режим технического обслуживания.

Так же, после того как вы отключили режим техобслуживания можно и вовсе деактивировать данный плагин. Затем, если понадобится, вы его снова активируете и включите режим обслуживания.

Ход эксперимента

В рамках проведения эксперимента были реализованы следующие шаги:

-

На двух разных документах были созданы группы ссылок. Одна из групп ссылок была скрыта через различные варианты JS, а вторая группа — посредством технологии AJAX.

Рис. 3. Иллюстрация страниц с экспериментом.

-

Анкоры ссылок состояли из слов, которые в такой же последовательности и точной форме не встречаются в тексте документа-акцептора.

-

При этом, отдельные слова из запроса должны были присутствовать в документе для того, чтобы документы прошли аналог «яндексовского» кворума в Google по ссылочному ранжированию.

-

Сами скрипты и подгружаемые ссылки были закрыты от индексации в файле robots.txt.

-

Далее следовало ожидание переиндексации документов в Google и Яндекс.

Комментарии в robots.txt

Комментарии в файле robots.txt пишутся после знака # и игнорируются поисковыми системами. Как правило, комментарии используются для обозначения причин открытия или закрытия для индексации определенных страниц, чтобы в будущем оптимизатору были понятны причины тех или иных правок в файле.

В данной статье вы уже встречались с комментирование, которое поясняло использование директив. Вот еще один пример:

#Это файл robots.txt. Все что написано в данной строке, роботы не прочтут User-agent: Yandex #Комментарий Disallow: /pink #закрыл от индексации, так как на странице неуникальный контент

Контент

Проблемы, связанные с закрытием контента на сайте:

Страница оценивается поисковыми роботами комплексно, а не только по текстовым показателям. Увлекаясь закрытием различных блоков, часто удаляется и важная для оценки полезности и ранжирования информация.

Приведём пример наиболее частых ошибок:

– прячется шапка сайта. В ней обычно размещается контактная информация, ссылки. Если шапка сайта закрыта, поисковики могут не узнать, что вы позаботились о посетителях и поместили важную информацию на видном месте;

Зачем на сайте закрывают часть контента?

Обычно есть несколько целей:

– сделать на странице акцент на основной контент, убрав из индекса вспомогательную информацию, служебные блоки, меню;

– сделать страницу более уникальной, полезной, убрав дублирующиеся на сайте блоки;

– убрать «лишний» текст, повысить текстовую релевантность страницы.

Всего этого можно достичь без того, чтобы прятать часть контента!У вас очень большое меню?

Выводите на страницах только те пункты, которые непосредственно относятся к разделу.

Много возможностей выбора в фильтрах?

Выводите в основном коде только популярные. Подгружайте остальные варианты, только если пользователь нажмёт кнопку «показать всё». Да, здесь используются скрипты, но никакого обмана нет – скрипт срабатывает по требованию пользователя. Найти все пункты поисковик сможет, но при оценке они не получат такое же значение, как основной контент страницы.

На странице большой блок с новостями?

Сократите их количество, выводите только заголовки или просто уберите блок новостей, если пользователи редко переходят по ссылкам в нём или на странице мало основного контента.

Поисковые роботы хоть и далеки от идеала, но постоянно совершенствуются. Уже сейчас Google показывает скрытие скриптов от индексирования как ошибку в панели Google Search Console (вкладка «Заблокированные ресурсы»). Не показывать часть контента роботам действительно может быть полезным, но это не метод оптимизации, а, скорее, временные «костыли», которые стоит использовать только при крайней необходимости.

Мы рекомендуем:

– относиться к скрытию контента, как к «костылю», и прибегать к нему только в крайних ситуациях, стремясь доработать саму страницу;

– удаляя со страницы часть контента, ориентироваться не только на текстовые показатели, но и оценивать удобство и информацию, влияющую на коммерческие факторы ранжирования;

– перед тем как прятать контент, проводить эксперимент на нескольких тестовых страницах. Поисковые боты умеют разбирать страницы и ваши опасения о снижение релевантности могут оказаться напрасными.

Давайте рассмотрим, какие методы используются, чтобы спрятать контент:

Тег noindex

У этого метода есть несколько недостатков. Прежде всего этот тег учитывает только Яндекс, поэтому для скрытия текста от Google он бесполезен

Помимо этого, важно понимать, что тег запрещает индексировать и показывать в поисковой выдаче только текст. На остальной контент, например, ссылки, он не распространяется

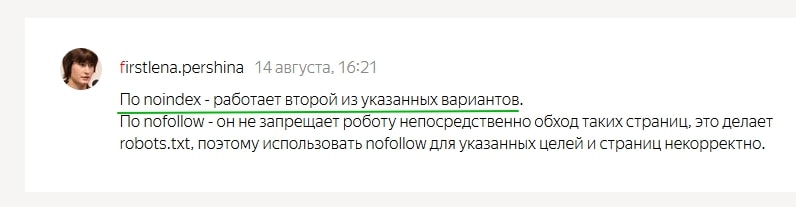

Это видно из самого .

Поддержка Яндекса не особо распространяется о том, как работает noindex. Чуть больше информации есть в одном из обсуждений в официальном блоге.

Вопрос пользователя:

Ответ:

В каких случаях может быть полезен тег:

– если есть подозрения, что страница понижена в выдаче Яндекса из-за переоптимизации, но при этом занимает ТОПовые позиции по важным фразам в Google. Нужно понимать, что это быстрое и временное решение. Если весь сайт попал под «Баден-Баден», noindex, как неоднократно подтверждали представители Яндекса, не поможет;

– чтобы скрыть общую служебную информацию, которую вы из-за корпоративных ли юридических нормативов должны указывать на странице;

– для корректировки сниппетов в Яндексе, если в них попадает нежелательный контент.

Скрытие контента с помощью AJAX

Это универсальный метод. Он позволяет спрятать контент и от Яндекса, и от Google. Если хотите почистить страницу от размывающего релевантность контента, лучше использовать именно его. Представители ПС такой метод, конечно, не приветствую и рекомендуют, чтобы поисковые роботы видели тот же контент, что и пользователи.

Технология использования AJAX широко распространена и если не заниматься явным клоакингом, санкции за её использование не грозят. Недостаток метода – вам всё-таки придётся закрывать доступ к скриптам, хотя и Яндекс и Google этого не рекомендуют делать.

Результаты эксперимента: AJAX

Результат проверки при скрытии посредством технологии AJAX показал, что не в одном из 5 случаев не Яндекс, ни Google не смогли распознать в данном контенте ссылок.

Как видит Google?

Рис. 12. Сохраненная копия в Google.

Видно, что Яндекс и Google воспринимают данный контент как обычный текст и не интерпретирует его как блок ссылок.

Дополнительно произведем поисков текстов ссылок в анкор-листе страниц акцепторов с помощью оператора «allinanchor».

Рис. 13. Проверка наличия текстов ссылок в анкор-листе акцепторов.

В анкор-листе страниц акцепторов фразы из текстов ссылок не были найдены. Это является дополнительным подтверждением того, что поисковые системы не смогли проиндексировать ссылки, скрытые посредством AJAX.

Карта сайта в robots.txt — Sitemap.xml

Директива Sitemap указывает поисковым роботам путь на xml карту сайта. Этот файл невероятно важен для поисковых систем, так как при обходе сайта они, в первую очередь, обращаются к нему. В данном файле представлена структура сайта со всем внутренними ссылками, датами создания страниц, приоритетами индексирования.

Пример robots.txt с указанием адреса карты сайта на нашем сайте:

User-agent: * Sitemap: https://naked-seo.ru/sitemal.xml

Наличии xml карты сайта улучшает представление вашего сайта в поисковой выдаче. Карта сайта является стандартом, который должен быть внедрен на каждом сайте. Частота обновления и актуальность поддержания sitemap.xml может серьезно ускорить индексирование страниц, особенно у молодого сайта.

Разрешить индексацию robots.txt — Allow

Allow — это директива разрешающая поисковому роботу обход страниц. Она является противоположностью директиве Disallow. В ней, как и в Disallow возможно использование спецсимволов * и $.

Давайте рассмотрим пример использования директивы Allow:

User-agent: * Disallow: / Allow: /blog

Данные инструкции разрешают обход раздела /blog, при этом весь остальной сайт остается недоступен для индексирования.

Пустой «Disallow: » = «Allow: /». Обе директивы разрешают полный обход сайтаПустой «Allow: » = «Disallow: /». Обе директивы полностью запрещают обход сайта.

Эта информация дана для справки. Широкого практического применения она не получает.

Индексация сайта в поиске

Теперь, когда мы рассказали, что такое индексация, почему она так важна и как её проверить, приступим к практике.

Как ускорить индексацию?

Мы писали выше, что управлять индексацией, что бы кто не говорил, вы не можете. Но повлиять на процесс или даже ускорить возможно.

Советы по ускорению индексации

- Обязательно добавьте сайт во все сервисы Яндекса и Google, особенно в Яндекс Вебмастер и Google Search Console.

- Создайте sitemap.xml, поместите карту в корень сайта и постоянно обновляйте.

- Следите за robots.txt и исключайте ненужные страницы (об этом ниже).

- Выберите надёжный и быстрый хостинг, чтобы робот мог беспрепятственно индексировать содержимое сайта.

- Используйте инструменты Яндекс Вебмастера (Индексирование → Переобход страниц) и Google Search Console (Проверка URL → Запросить индексирование). Способ идеально подходит для работы с отдельными страницами.

- Если ваша CMS любит создавать дубли (например, Битрикс), то используйте атрибут rel=canonical.

- Автоматизируйте создание новых ссылок со старых страниц. Как вариант, можно сделать блок на главной с новыми товарами или статьями.

- Ведите соцсети и анонсируйте новые товары, услуги, страницы. Замечено, что ссылки с соцсетей могут ускорить процесс.

- Создавайте качественный контент на каждой странице. Под качественным контентом мы понимаем актуальную, релевантную и уникальную информацию для пользователей.

- Работайте над структурой сайта и делайте её удобной и понятной пользователю. Помните о правиле 3 кликов: это оптимальное количество действий для пользователя.

- Проверяйте периодически сайт на вирусы и санкции поисковых систем. В Яндекс Вебмастере раздел Диагностика → Безопасность и нарушения, в Google Search Console — раздел Проблемы безопасности и меры, принятые вручную.

- Улучшайте свой ссылочный профиль и пишите анонсы на других сайтах (в рамках правил поисковых систем).

- Используйте родные браузеры (Chrome, Яндекс Браузер) и заходите на новые страницы с них.

Как запретить индексацию?

Выше мы рассмотрели основные способы, как ускорить индексацию, и рассказали, что такое краулинговый бюджет и почему он ограничен для каждого сайта. Поэтому чтобы его не тратить зря, советуем закрывать от индексации служебные и технические страницы, кабинеты пользователей и конфиденциальную информацию, а также страницы в разработке и дубли.

3 основных способа запретить индексацию:

- Директива Disallow в файле robots. Мы писали, что такой запрет может не сработать в отдельных случаях. Тем не менее это основной способ запрета индексации.

- В коде страницы указать метатег robots с директивой noindex (для текста) и/или nofollow (для ссылок). Хорошо подходит для запрета индексации отдельных страниц.

- Настроить HTTP-заголовок X-Robots-Tag с директивой noindex и/или nofollow. Лучше всего подходит для закрытия индексации не HTML-файлов (PDF, изображения, видео и другие).

Используйте все наши советы по улучшению индексации на полную мощь.

Максимальное внимание уделите улучшению структуры и навигации и обновлению карты сайта.

Структура сайта должна быть проста и понятна, охватывать весь спектр ключевых запросов, а каждая страница сайта в идеале должна быть доступна в 3–4 клика

Для этого используйте дополнительные блоки на главной странице и в разделах.

Хорошо работает облако тегов: с помощью него часто получается продвигать категории, улучшать навигацию и полно охватывать семантику.

Для многостраничных сайтов действительно важно постоянно обновлять sitemap.xml

Зачастую в таких случаях карту делят на несколько частей, чтобы охватить весь список страниц.

Настройте маски (автоматические шаблоны) метатегов для новых страниц в категориях и каталогах.

Скорее всего, вам не обойтись без команды профессионалов, которые смогут обеспечить техподдержку, производство контента и SEO-продвижение.

Запрещаем индексацию страницы

Запрет индексации одной единственной страницы отличается от запрета всего сайта только наличием дополнительной инструкции и URL адреса. Причем исключить из индекса можно не только конкретный адрес, но и маску. Однако возможность эта имеется только при работе с файлом robots.txt.

При помощи robots.txt

Для запрета конкретной страницы (спектра страниц по маске) используется инструкция «Disallow:». Синтаксис крайне простой:

Disallow: /wp-admin (исключаем всю папку wp-admin) Disallow: /wp-content/plugins (исключаем папку plugins, которая находится в wp-content) Disallow: /img/images.jpg (исключаем изображение images.jpg, которое находится в папке img) Disallow: /dogovor.pdf (исключаем файл /dogovor.pdf) Disallow: */trackback (исключаем папку trackback в любой папке первого уровня) Disallow: /*my (исключаем любую папку заканчивающуюся на my)

Все достаточно просто, не правда ли? Но это позволяет избавиться от множества проблем во время продвижения сайта. Актуализируйте robots.txt каждый месяц в зависимости от апдейтов Яндекса и Гугла.

При помощи тэгов

Исключение возможно и при помощи тэга <meta name=»robots» content=»noindex»>. Для этого необходимо просто вписать его в код конкретной страницы, которую Вы хотите закрыть от поисковиков.

Данный тэг размещается в <head> сайта, наряду с другими meta тэгами.

Стоит отметить, что значение параметра «content» может быть не только «noindex». Рассмотрим все возможные варианты.

| noindex | Самый распространенный параметр. Запрещает индексацию. |

| index | Обратный предыдущему параметр. Разрешает индексацию. Обычно не применяется, так как поисковая система по умолчанию индексирует все. |

| follow | Разрешает следовать по ссылкам, которые расположены на странице. Так же редко применяется, так как и без данного тэга будет переходить по ссылкам. |

| nofollow | Запрещает переходить по ссылкам. |

Как проверить файл robots.txt?

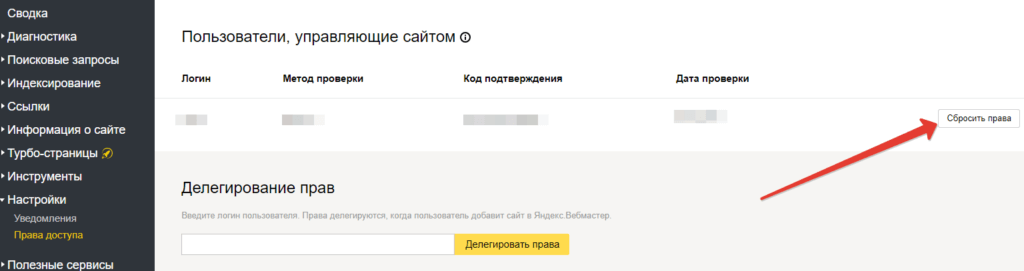

После добавления файла robots.txt на сайт Вы можете проверить корректность его настройки. Для этого поисковые системы предлагают специальные инструменты. В статье рассмотрим инструмент от Яндекса, который позволяет проверить правильность настройки robots.txt. Он доступен в сервисе Яндекс.Вебмастер во вкладке «Инструменты» – «Анализ robots.txt».

В верхней части страницы Вы можете увидеть проверяемый сайт (на скриншоте затерт), содержание файла robots.txt, известное Яндексу. Обязательно проверьте, что содержание файла указано корректно. Если в Яндекс.Вебмастер выводятся старые команды, нажмите на кнопку «Загрузить» (серый значок справа от ссылки на проверяемый сайт, выделен на скриншоте рамкой):

В нижней части страницы добавьте в поле «Разрешены ли URL?» список страниц, по которым Вы хотите проверить, разрешена их индексация или нет. Нажмите кнопку «Проверить», и ниже выведутся результаты. Красный значок означает, что страница запрещена к индексации, зеленый – разрешена:

Аналогичные инструменты проверки файла имеются в Центре вебмастеров Google.

Время от времени в структуру сайта вносятся изменения. Поэтому необходимо периодически проверять, какие страницы и документы находятся в индексе поисковых систем. При появлении в индексе документов, которые не должны там быть, их индексацию необходимо закрыть в файле robots.txt.

Рекомендуем

Как подобрать ключевые слова для продвижения сайта?

Выбор ключевых слов – один из важнейших этапов продвижения сайта. Все дальнейшие усилия не принесут эффекта, если Вы неправильно подберете …

Как рассчитать стоимость продвижения сайта?

В данной статье я расскажу, как рассчитать стоимость продвижения сайта и от чего зависит цена на услуги SEO-специалиста. Мы рассмотрим три …

Директива Clean-param в robots.txt

Чтобы поисковые роботы не обходили данные страницы, и лишний раз не нагружали ваш сервер, используйте директиву Clean-param, которая позволит оставить в выдаче только исходный документ.

https://naked-seo.ru/books/get_book.pl?userID=1&source=site_1&book_id=3 https://naked-seo.ru/books/get_book.pl?userID=2&source=site_2&book_id=3 https://naked-seo.ru/books/get_book.pl?userID=3&source=site_3&book_id=3

Параметр userID, который содержится в каждом url-адресе показывает персональный идентификатор пользователя, а параметр source показывает источник, из которого посетитель попал к нам на сайт. По трем разным url-адресам пользователи видят один и тот же контент book_id=3. В данном случае нам необходимо использовать директиву Clean-param следующим образом:

User-agent: Yandex Clean-param: userID /books/get_book.pl Clean-param: source /books/get_book.pl

Данные директивы помогут поисковому роботу Яндекса свести все динамические параметры в единую страницу:

https://naked-seo.ru/books/get_book.pl?&book_id=3

Если на сайте доступна такая страница, то именно она будет индексироваться и участвовать в выдаче.

Ошибки, на которые следует обратить внимание

Если после выполнения вышеописанных манипуляций у вас не получилось отключить индексацию, рекомендую обратить внимание на несколько моментов. В первую очередь проверьте логичность команд

Очень часто они противоречат друг другу, из-за чего не работают. Найти подобные ошибки можно посредством проверки robots.txt при помощи соответствующих инструментов в кабинете вебмастера.

Другой пласт распространённых ошибок – синтаксические. В данном случае подразумевается неправильная запись команд в файле. Рекомендую проверять файл сразу же после внесения нужных команд: так можно будет заранее найти ошибки и не тратить время на их поиск в будущем. На этом тему закрытия от индексации можно закончить. Вы можете подписаться на информационную рассылку для того, чтобы постоянно быть в курсе выхода новых полезных публикаций

Благодарю за внимание, всего хорошего!

Закрываем от индексации поисковиков

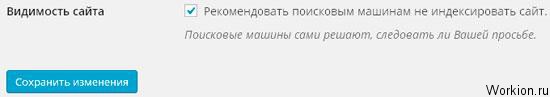

Перед тем как рассказать о способе с применением robots.txt, мы покажем, как на WordPress закрыть от индексации сайт через админку. В настройках (раздел чтение), есть удобная функция:

Можно убрать видимость сайта, но обратите внимание на подсказку. В ней говорится, что поисковые системы всё же могут индексировать ресурс, поэтому лучше воспользоваться проверенным способом и добавить нужный код в robots.txt

Текстовый файл robots находится в корне сайта, а если его там нет, создайте его через блокнот.

Закрыть сайт от индексации поможет следующий код:

User-agent: *

Disallow: /

Просто добавьте его на первую строчку (замените уже имеющиеся строчки). Если нужно закрыть сайт только от Яндекса, вместо звездочки указывайте Yandex, если закрываете ресурс от Google, вставляйте Googlebot.

Когда проделаете эти действия, сайт больше не будет индексироваться, это самый лучший способ для закрытия ресурса от поисковых роботов.

Запрещаем индексацию сайта

Для того, что бы полностью запретить индексацию сайта, необходимо, что бы при обращении к нему робот получал запрет в виде инструкции. Сделать это можно двумя способами.

При помощи robots.txt

Это наиболее распространенный и менее трудозатратный способ. Для того, что бы полностью закрыть сайт необходимо прописать в файле robots.txt простую инструкцию:

User-agent: * Disallow: /

Таким образом вы запрещаете индексацию для любой поисковой системы. Но есть возможность запрета и для конкретного поисковика, к примеру, Яндекса.

User-agent: Yandex Disallow: /

Подробнее о синтаксисе и работе с файлом robots.txt — https://dh-agency.ru/category/vnutrennyaya-optimizaciya/robots-txt/

При помощи тэгов

Так же, существует способ закрыть свой сайт при помощи специального тэга. Он будет «говорить» индексирующему роботу при обращении к странице, что ее загружать не надо.

<meta name=»robots» content=»noindex»>

Данный тэг необходимо разместить на каждой странице Вашего сайта.

Параметр поля «name» зависит от робота, к которому Вы обращаетесь. К примеру, если речь идет о роботе Google, то данный тэг будет выглядеть следующим образом:

<meta name=»googlebot» content=»noindex»>

О том, какие значения может принимать параметр «content», читайте .

Вывод

Контент закрытого типа бывает разных форм и размеров. Вы можете создавать разделы вашего сайта только для членов, скрывать электронные книги за подпиской по электронной почте и многое другое. Пока контент, который вы скрываете, достаточно ценен, этот подход должен помочь вам собрать больше потенциальных клиентов.

Добавить закрытый контент в WordPress просто, и вы можете сделать это в четыре шага:

- Создайте свой сайт следующим.

- Решите, что будет включать ваш закрытый контент.

- Используйте плагин, такой как Simple Membership, чтобы ограничить доступ к закрытому контенту.

- Скрыть ваш закрытый контент от поисковых систем.

У вас есть вопросы о том, как внедрить закрытый контент на ваш сайт WordPress? Задайте вопрос в разделе комментариев ниже!